실제로 서비스를 설계하고 운영해본 경험에서 나온 조언들이 담겨 있어 이론서와 차별화된 내용이 들어있어서 실무에 많은 도움이 되었습니다.

생성형 AI의 경쟁력을 높이는 LLM 최적화 전략

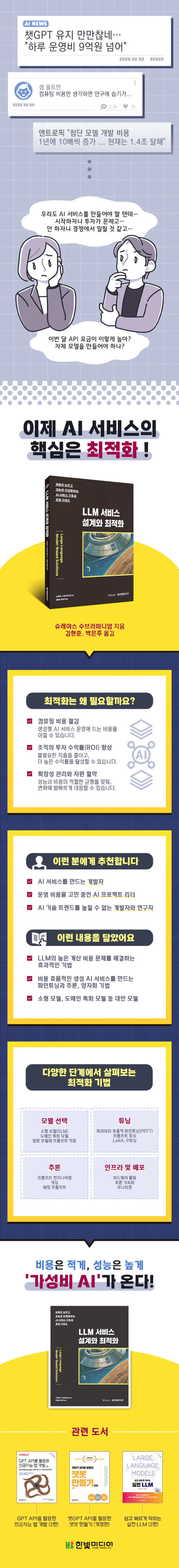

AI와 머신러닝의 발전으로 거대 언어 모델(LLM)에 대한 관심은 급증했지만, 높은 비용 때문에 수많은 기업이 도입을 주저하고 있습니다. 이 책은 적은 비용으로 LLM을 구축하고 배포하는 효율적인 접근법을 소개합니다. 모델 선택, 프롬프트 엔지니어링, 파인튜닝, 배포의 각 단계에서 성능을 지나치게 희생하지 않으면서 비용을 최소화하는 방법을 만나 보세요.

검색 시스템이나 AI 에이전트와 같은 생성형 AI 애플리케이션 구현에 필요한 실용적이고 기술적인 지식을 제공합니다. 모델 양자화, 스케일링 등의 추론 최적화 기법과 인프라 비용 절감 방법을 탐구하여 생성형 AI 서비스의 경쟁력을 강화해 보세요.

CHAPTER 1 LLM 기초

_1.1 생성형 AI 애플리케이션과 LLM

_1.2 생성형 AI 애플리케이션의 상용화를 위한 길

_1.3 비용 최적화의 중요성

_1.4 요약

CHAPTER 2 비용 최적화를 위한 튜닝 기법

_2.1 파인튜닝 및 커스터마이징

_2.2 파라미터 효율적 파인튜닝(PEFT)

_2.3 PEFT의 비용 및 성능에 대한 영향

_2.4 요약

CHAPTER 3 비용 최적화를 위한 추론 테크닉

_3.1 추론 테크닉 소개

_3.2 프롬프트 엔지니어링

_3.3 벡터 스토어를 이용한 캐싱

_3.4 긴 문서를 관리하는 체인

_3.5 텍스트 요약

_3.6 효율적인 추론을 위한 배칭 프롬프트

_3.7 모델 최적화 방법

_3.8 파라미터 효율적 파인튜닝(PEFT)

_3.9 비용 및 성능 영향

_3.10 요약

CHAPTER 4 모델 선택과 대안

_4.1 모델 선택의 중요성

_4.2 효율적인 소형 모델

_4.3 성공적인 소형 모델 사례

_4.4 도메인 특화 모델

_4.5 범용 모델을 활용한 프롬프트의 성능

_4.6 요약

CHAPTER 5 인프라 및 배포 튜닝 전략

_5.1 튜닝 전략

_5.2 하드웨어 활용 및 배치 튜닝

_5.3 추론 가속화 도구

_5.4 모니터링과 옵저버빌리티

_5.5 요약

CHAPTER 6 성공적인 생성형 AI 도입의 열쇠

_6.1 성능과 비용의 균형

_6.2 생성형 AI 애플리케이션의 미래 트렌드

_6.3 요약

이제 AI 서비스의 핵심은 최적화!

LLM 서비스 설계의 모든 것을 배운다!

딥시크처럼 적은 투자로 높은 성능을 내는 LLM이 등장하며, AI 개발 과정에 최적화라는 키워드가 새로이 떠올랐습니다. 이 책은 소형 모델(SLM) 활용법, 효과적인 프롬프트 엔지니어링, 파인튜닝, 양자화 기법까지, 기업과 개발자들이 효율적인 투자로 고성능의 AI 서비스를 구축하는 데 필요한 모든 방법론과 이론을 다룹니다. 다양한 이론과 사례 연구로 효과적인 인사이트를 얻어 보세요. AI 기술 도입 비용으로 고민하는 국내 스타트업과 기업, 개발자라면 반드시 참고해야 할 지침서입니다.

주요 내용

대상 독자