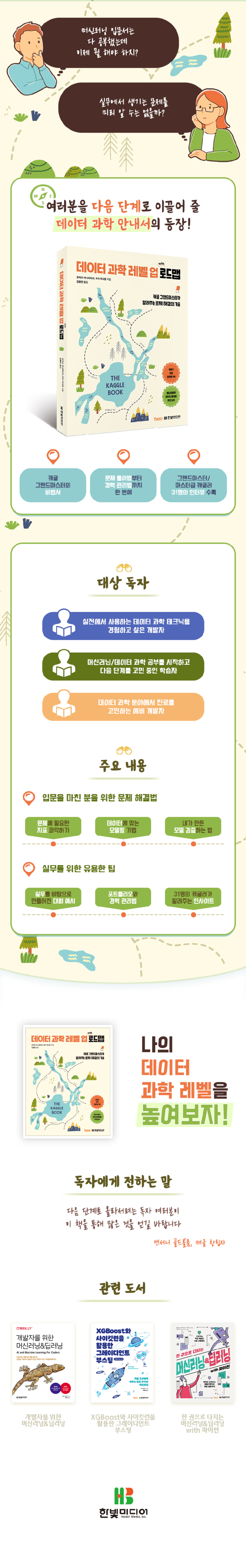

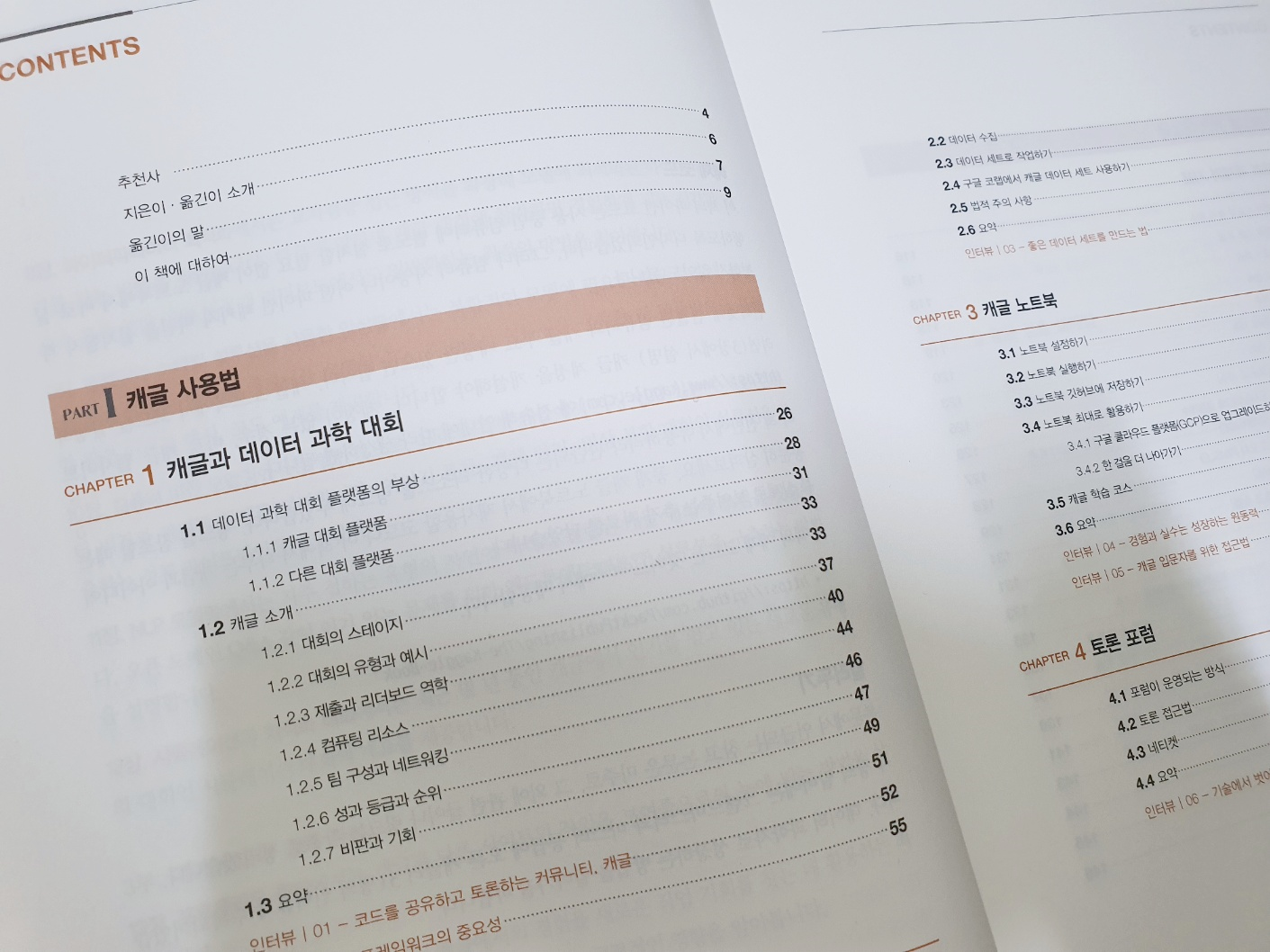

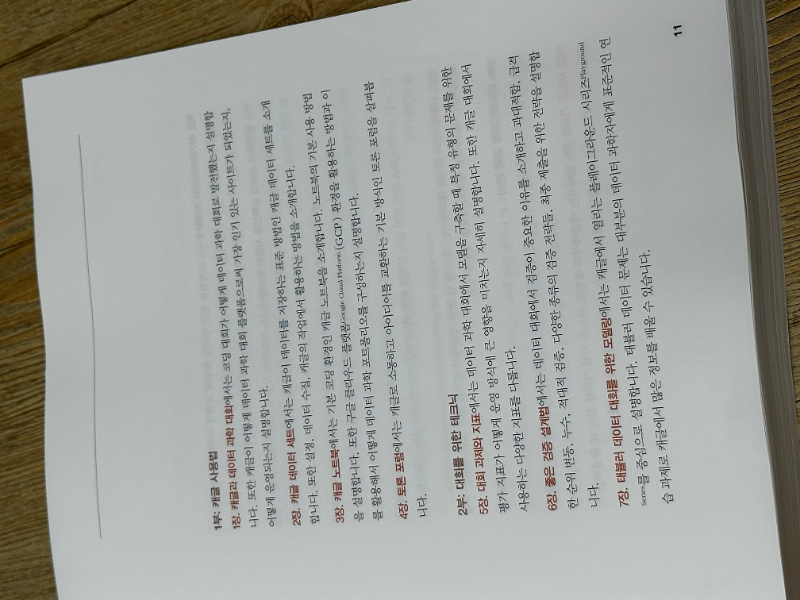

PART I 캐글 사용법

CHAPTER 1 캐글과 데이터 과학 대회

_1.1 데이터 과학 대회 플랫폼의 부상

__1.1.1 캐글 대회 플랫폼

__1.1.2 다른 대회 플랫폼

_1.2 캐글 소개

__1.2.1 대회의 스테이지

__1.2.2 대회의 유형과 예시

__1.2.3 제출과 리더보드 역학

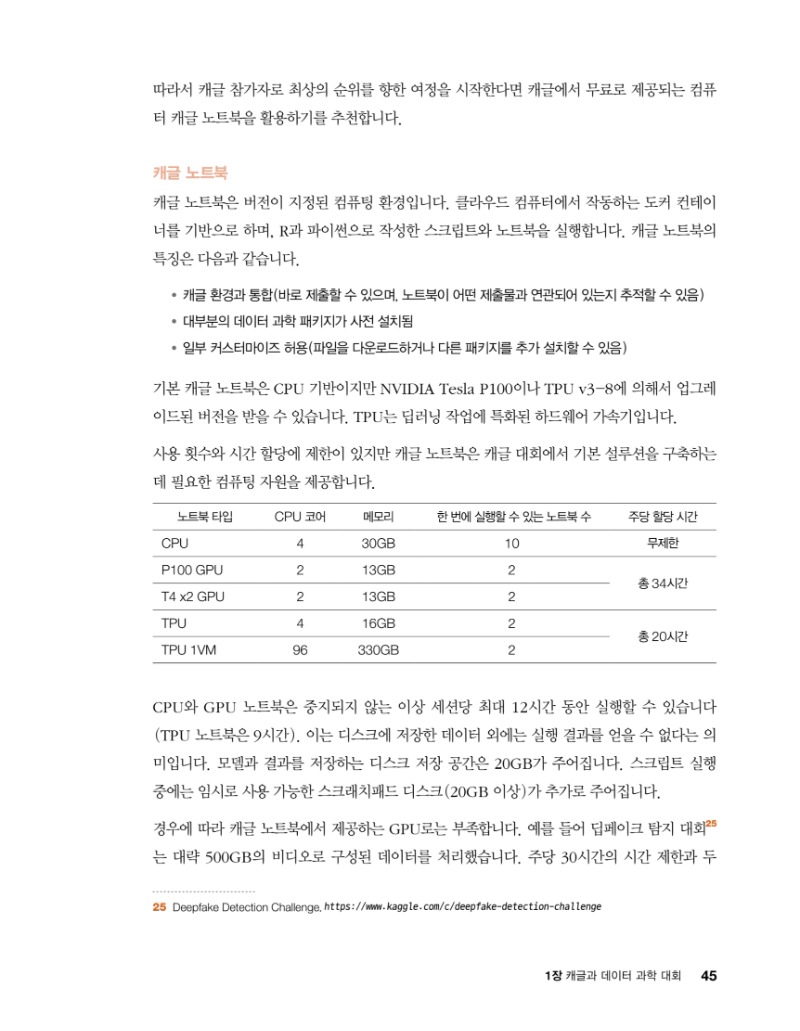

__1.2.4 컴퓨팅 리소스

__1.2.5 팀 구성과 네트워킹

__1.2.6 성과 등급과 순위

__1.2.7 비판과 기회

_1.3 요약

인터뷰 | 01 - 코드를 공유하고 토론하는 커뮤니티, 캐글

인터뷰 | 02 - 프레임워크의 중요성

CHAPTER 2 캐글 데이터 세트

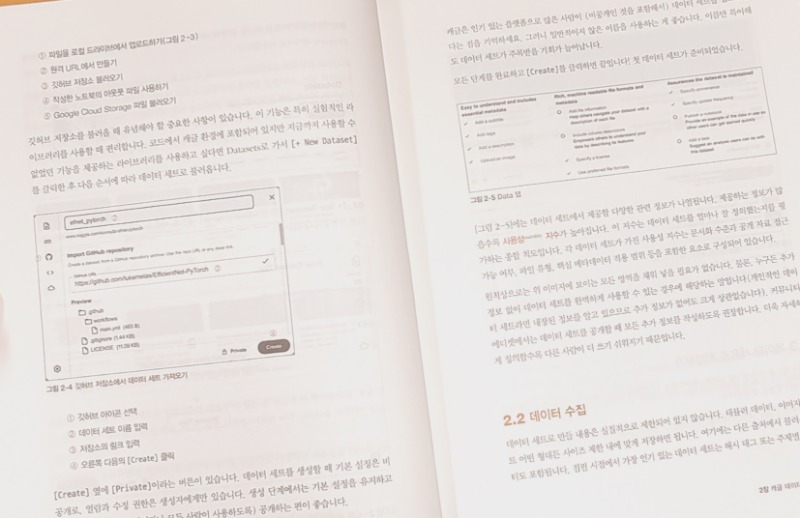

_2.1 데이터 세트 준비하기

_2.2 데이터 수집

_2.3 데이터 세트로 작업하기

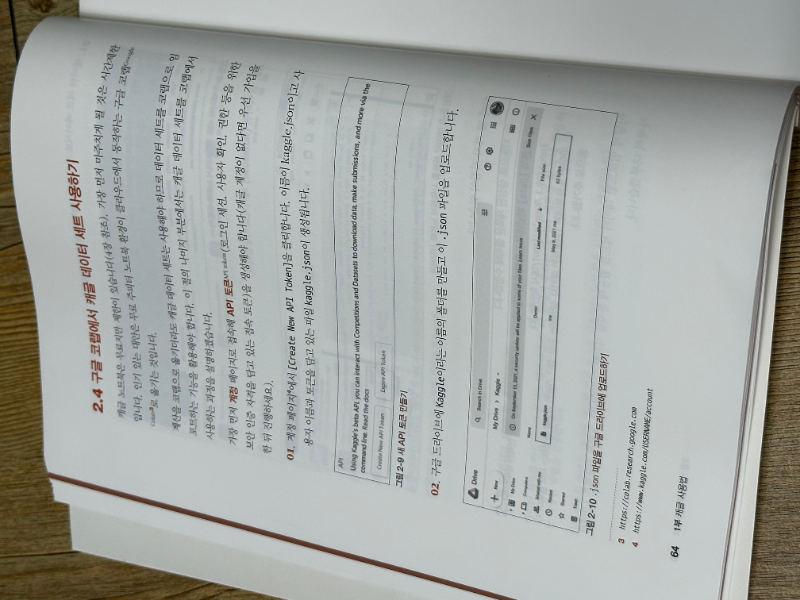

_2.4 구글 코랩에서 캐글 데이터 세트 사용하기

_2.5 법적 주의 사항

_2.6 요약

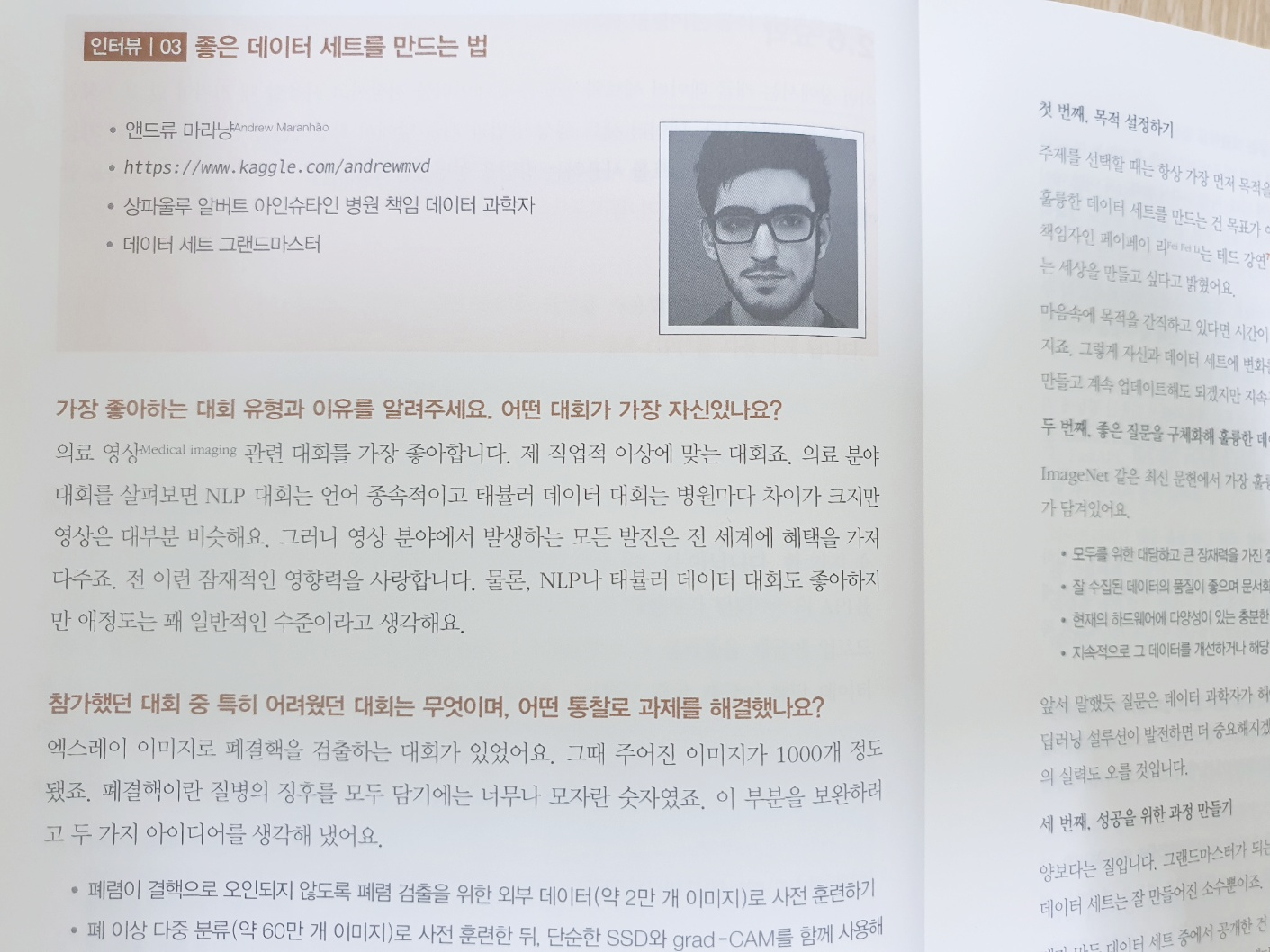

인터뷰 | 03 - 좋은 데이터 세트를 만드는 법

CHAPTER 3 캐글 노트북

_3.1 노트북 설정하기

_3.2 노트북 실행하기

_3.3 노트북 깃허브에 저장하기

_3.4 노트북 최대로 활용하기

__3.4.1 구글 클라우드 플랫폼(GCP)으로 업그레이드하기

__3.4.2 한 걸음 더 나아가기

_3.5 캐글 학습 코스

_3.6 요약

인터뷰 | 04 - 경험과 실수는 성장하는 원동력

인터뷰 | 05 - 캐글 입문자를 위한 접근법

CHAPTER 4 토론 포럼

_4.1 포럼이 운영되는 방식

_4.2 토론 접근법

_4.3 네티켓

_4.4 요약

인터뷰 | 06 - 기술에서 벗어나 맥락에서 정보를 찾아라

PART II 대회를 위한 테크닉

CHAPTER 5 대회 과제와 지표

_5.1 평가 지표와 목적 함수

_5.2 과제의 기본 유형

__5.2.1 회귀

__5.2.2 분류

__5.2.3 서수

_5.3 메타 캐글 데이터 세트

_5.4 처음 보는 지표 처리

_5.5 회귀를 위한 지표(표준과 서수)

__5.5.1 평균 제곱 오차(MSE)와 결정계수

__5.5.2 평균 제곱근 오차(RMSE)

__5.5.3 평균 제곱근 로그 오차(RMSLE)

__5.5.4 평균 절대 오차(MAE)

_5.6 분류를 위한 지표(레이블 예측과 확률)

__5.6.1 정확도

__5.6.2 정밀도와 재현율

__5.6.3 F1 점수

__5.6.4 로그 손실과 ROC-AUC

__5.6.5 매튜스 상관계수(MCC)

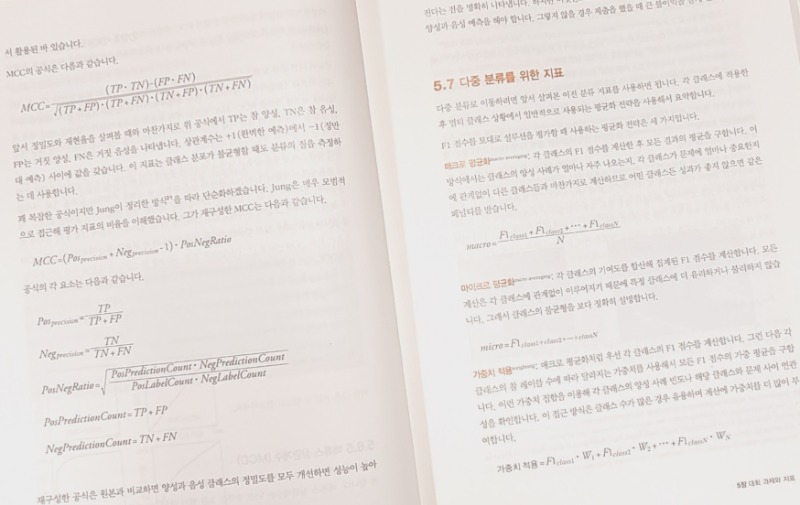

_5.7 다중 분류를 위한 지표

_5.8 객체 탐지를 위한 지표

__5.8.1 IoU

__5.8.2 다이스

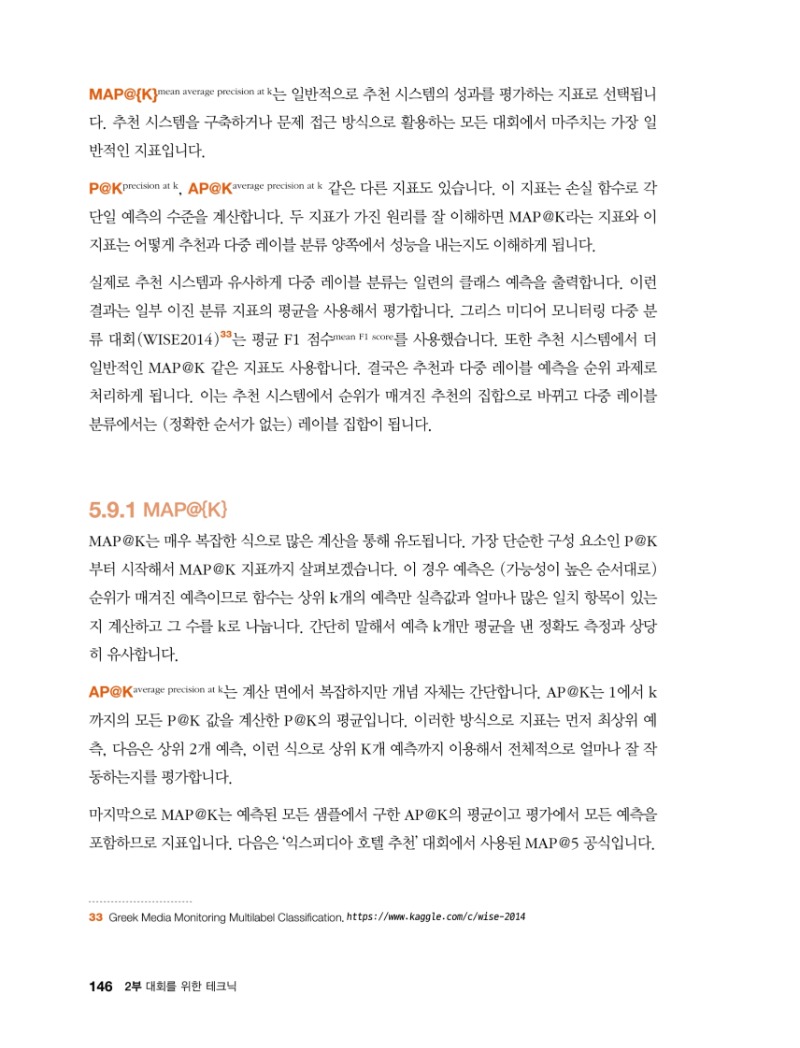

_5.9 다중 레이블 분류와 추천을 위한 지표

__5.9.1 MAP@{K}

_5.10 평가 지표 최적화

__5.10.1 사용자 정의 지표와 사용자 정의 목표 함수

__5.10.2 예측 후처리

_5.11 요약

인터뷰 | 07 - 전분야 그랜드마스터의 문제 접근법

인터뷰 | 08 - 장기적인 목표를 잡아라

인터뷰 | 09 - 핵심은 꾸준함

CHAPTER 6 좋은 검증 설계법

_6.1 리더보드 분석

_6.2 대회에서 검증의 중요성

__6.2.1 편향과 분산

_6.3 다양한 분할 전략 시도

__6.3.1 기본 훈련 세트 분할

__6.3.2 확률적 평가 방법

_6.4 모델 검증 시스템 조정

_6.5 적대적 검증 사용

__6.5.1 구현 예시

__6.5.2 훈련 데이터와 테스트 데이터의 분포 차이 처리

_6.6 누수 처리

_6.7 요약

인터뷰 | 10 - 모든 것을 검증하라

인터뷰 | 11 - 여러 아이디어로 만드는 좋은 검증

인터뷰 | 12 - 캐글은 마라톤이다

CHAPTER 7 태뷸러 데이터 대회를 위한 모델링

_7.1 플레이그라운드 시리즈

_7.2 재현성을 위한 랜덤 상태 설정

_7.3 EDA의 중요성

__7.3.1 t-SNE과 UMAP으로 차원 축소하기

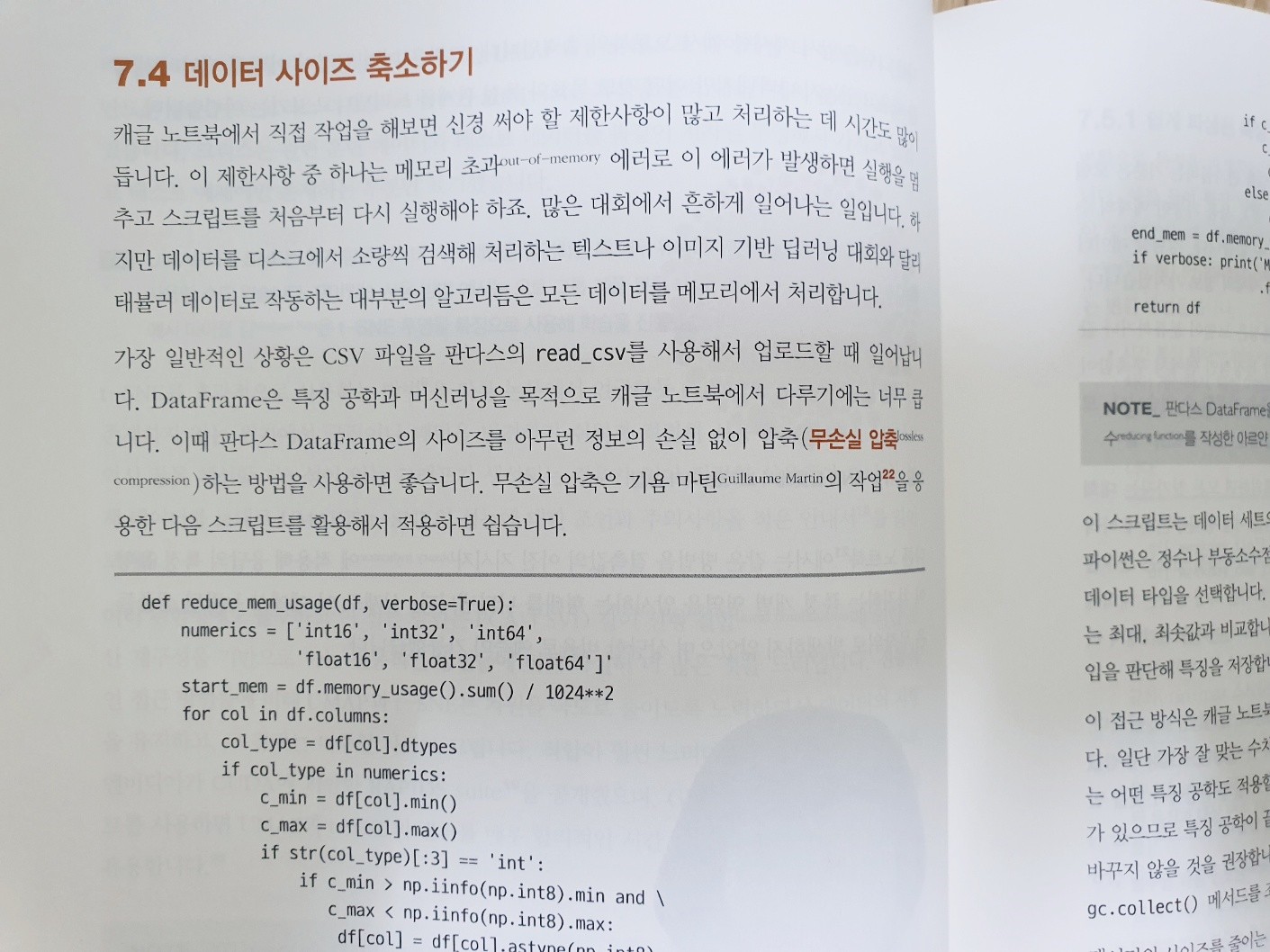

_7.4 데이터 사이즈 축소하기

_7.5 특징 공학 적용하기

__7.5.1 쉽게 파생된 특징

__7.5.2 행과 열에 기반한 메타 특징

__7.5.3 목표 인코딩

__7.5.4 특징의 중요도 활용해서 작업 평가하기

_7.6 의사 레이블링

_7.7 오토인코더로 잡음 제거하기

_7.8 태뷸러 데이터 대회를 위한 신경망

_7.9 요약

인터뷰 | 13 - 게임처럼 접근하라

인터뷰 | 14 - 데이터 과학도 과학이다

CHAPTER 8 하이퍼파라미터 최적화

_8.1 기본 최적화 기법

__8.1.1 그리드 탐색

__8.1.2 랜덤 탐색

__8.1.3 분할 탐색

_8.2 핵심 파라미터와 사용 방법

__8.2.1 선형 모델

__8.2.2 서포트 벡터 머신

__8.2.3 랜덤 포레스트와 극단적 랜덤 트리

__8.2.4 그레이디언트 트리 부스팅

_8.3 베이지언 최적화

__8.3.1 scikit-optimize 사용하기

__8.3.2 베이지언 최적화 탐색 커스터마이징하기

__8.3.3 베이지언 최적화를 신경망 구조 탐색(NAS)으로 확장하기

__8.3.4 KerasTunner로 더 가볍고 빠른 모델 생성하기

__8.3.5 Optuna의 TPE 접근

_8.4 요약

인터뷰 | 15 - 배우는 게 있다면 실패가 아니다

인터뷰 | 16 - 문제와 데이터부터 이해하라

인터뷰 | 17 - 도전하는 용기

CHAPTER 9 블렌딩과 스태킹 설루션을 사용한 앙상블

_9.1 앙상블 알고리듬

_9.2 모델 평균화로 앙상블하기

__9.2.1 다수결 투표 알고리듬

__9.2.2 모델 예측의 평균화

__9.2.3 가중 평균

__9.2.4 교차검증 전략의 평균화

__9.2.5 ROC-AUC 평가를 위한 평균 수정

_9.3 메타 모델을 사용한 모델 블렌딩

__9.3.1 모델 블렌딩의 모범 사례

_9.4 모델 스태킹

__9.4.1 스태킹 변형

_9.5 복잡한 스태킹과 블렌딩 설루션 만들기

_9.6 요약

인터뷰 | 18 - 데이터를 이해하면 프로젝트가 시작된다

인터뷰 | 19 - 새로운 영역에 겁내지 말 것

CHAPTER 10 컴퓨터 비전 모델링

_10.1 증강 전략

__10.1.1 케라스 내장 증강

__10.1.2 Albumentations

_10.2 분류

_10.3 객체 탐지

_10.4 시맨틱 분할

_10.5 요약

인터뷰 | 20 - 배우고 즐겨라

인터뷰 | 21 - 모든 대회는 퍼즐을 해결하는 모험

CHAPTER 11 NLP 모델링

_11.1 감정 분석

_11.2 오픈 도메인 Q&A

_11.3 텍스트 데이터 증강 전략

__11.3.1 기본 테크닉

__11.3.2 nlpaug

_11.4 요약

인터뷰 | 22 - 스스로의 아이디어로 시작하라

인터뷰 | 23 - 신문사 데이터 과학자가 텍스트를 다루는 법

CHAPTER 12 시뮬레이션과 최적화 대회

_12.1 Connect X

_12.2 가위바위보

_12.3 산타 대회 2020

_12.4 Halite

_12.5 요약

인터뷰 | 24 - 성장을 돕는 캐글

PART III 데이터 과학 경력 관리

CHAPTER 13 포트폴리오 준비

_13.1 캐글로 포트폴리오 구축하기

__13.1.1 노트북과 토론 활용하기

_13.2 캐글을 넘어 온라인에 존재감 드러내기

__13.2.1 블로그

__13.2.2 깃허브

_13.3 대회 최신 소식과 뉴스레터 모니터링하기

_13.4 요약

인터뷰 | 25 - 대회에서 얻은 새로운 기회

인터뷰 | 26 - 칭찬은 캐글러를 춤추게 한다

CHAPTER 14 새로운 기회를 찾는 법

_14.1 대회에 참여한 다른 데이터 과학자와 관계 구축하기

_14.2 캐글 데이와 캐글 밋업에 참가하기

_14.3 주목받는 방법과 다른 직업 기회들

__14.3.1 STAR 접근법

_14.4 요약

인터뷰 | 27 - 단기적인 피드백으로 개선하는 장기 연구

인터뷰 | 28 - 비전공자의 데이터 과학 도전기

인터뷰 | 29 - 16세에 그랜드마스터가 된 이야기

인터뷰 | 30 - 캐글이 만든 커리어

인터뷰 | 31 - 대회의 목적은 우승이 아닌 배움

마무리